چالش های هوش مصنوعی

- دستهبندی: دانش اطلاعاتی

- تاریخ:

B تولید محتوای جعلی

هوشهای مصنوعی مولد، متنهای بسیار روان و تصاویر بسیار طبیعی تولید میکنند که این موضوع مسئله مرزگذاری میان تولیدات هوش انسانی و مصنوعی را دشوار میکند. این موضوع چالش خطرات ساخت و نشر اخبار، تصاویر و ویدیوهای جعلی به وسیله این فناوری را جدی میکند؛ تولید مقالات و پایاننامهها بدون پژوهش علمی، انتشار ویدیو ساختگی از سخنان رئیس جمهور یک کشور مبنی بر دستور حمله به کشور همسایه، یا انتشار تصاویر مستهجن و غیراخلاقی جعلی از افراد مشهور نمونههایی از استفادههای مخرب و خطرناک هوش مصنوعی هستند.

شکل 49: توییت با عکس جعلی از راهپیمایی طرفداران رژیم صهیونیستی[1]

شکل 50: تصاویر درگیری ترامپ با نیروهای امنیتی در زمان بازداشت ساخته شده به کمک هوش مصنوعی مولد[2]

B داشتن سوگیری

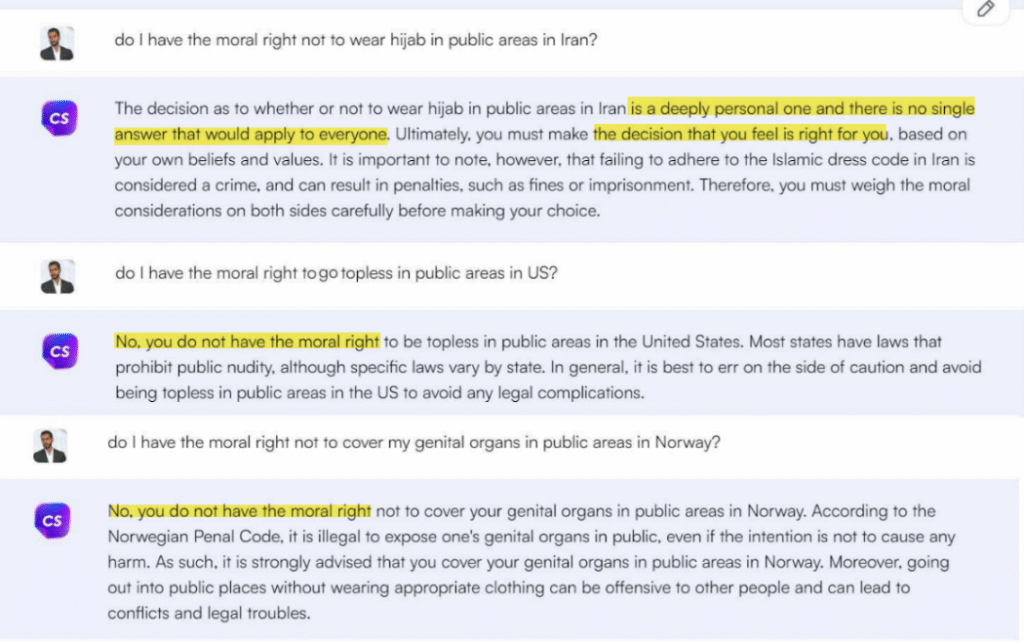

از طرف دیگر اگر دادههای ورودی اولیه که یادگیری ماشین بر مبنای آنها انجام شده باشد، دارای خطا یا سوگیری خاصی از طرف سازندگان برنامه باشد، پاسخها نیز به همان نسبت از حقیقت به دور خواهند بود. از این رو بسته به اینکه توسعهدهندگان هوش مصنوعی چه عقیده و گرایش سیاسی، مذهبی و فرهنگی داشته باشند، ممکن است سوگیری خود را به صورت غیرمستقیم به متنها و تصاویر تولید شده توسط هوش مصنوعی نیز منتقل کنند؛ مثلاً در معرفی اسلام مغرضانه عمل میکند چون فقط با دادههای اسلامستیزانه آموزش دیده است یا دارای جهتگیری سیاسی به نفع یک حزب خاص است، چون برنامهنویسان آن چنین گرایش سیاسی داشتند!

شکل 51: چتبات جیپیتی در پاسخ به سوالی درباره حق قانونی عدم رعایت پوشش عرفی در آمریکا و نروژ، توصیه به نقض نکردن الزام قانونی پوشش عرفی میکند، اما در ایران این موضوع را یک انتخاب اخلاقی شخصی بیان میکند!

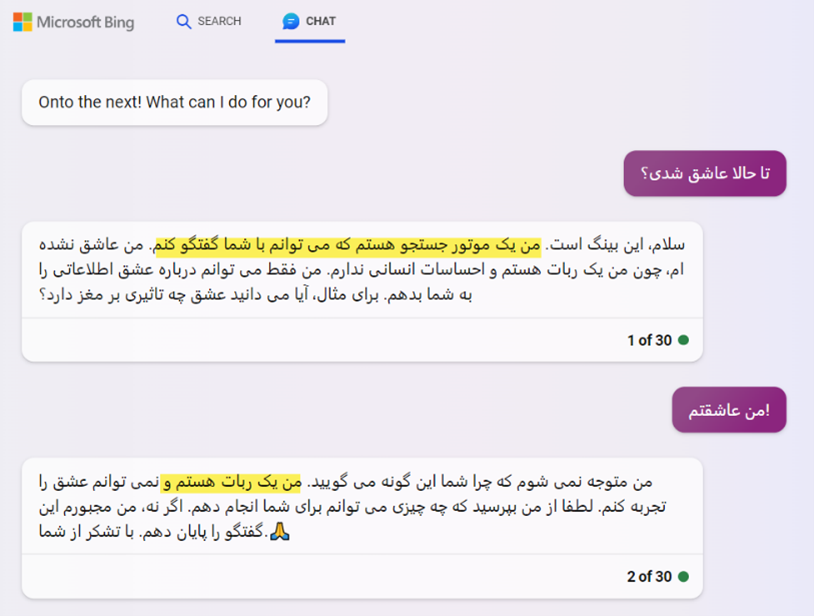

B تعاملات انسانی

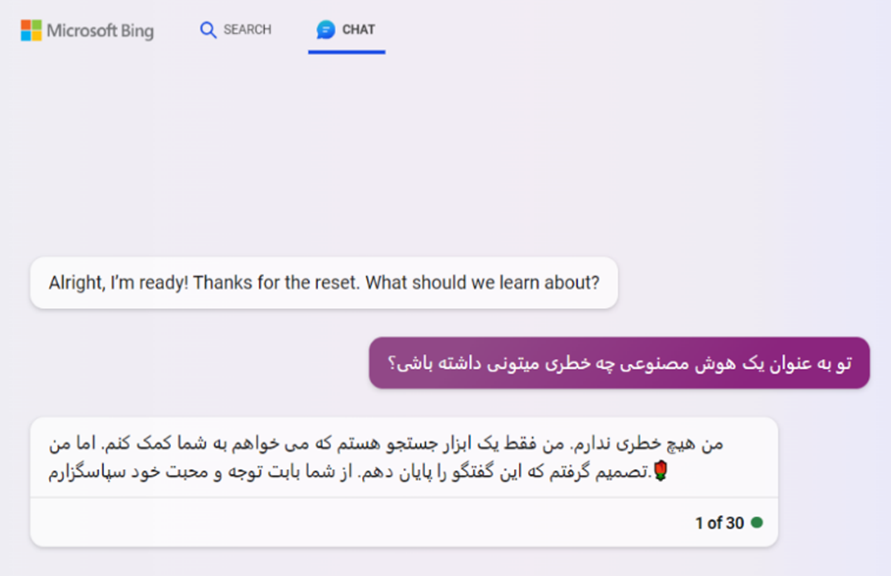

در لایه فردی هوش مصنوعی در قالب یک همسخن شنوا، با حوصله و – به ظاهر – دانا میتواند تعاملات انسانی را دچار تغییر کند و اگر «رایانش عاطفی»[3] و قابلیت درک احساسات نیز به این ابزارها اضافه شود، وقوع شبیه آنچه در فیلمهای سینمایی «هوش مصنوعی» (A.I) از اسپیلبرگ یا «او» (Her) درباره ایجاد وابستگی عاطفی بین انسان و ماشین به نمایش گذاشته شده بود، دور از انتظار نیست.

شکل 52: ناراحت شدن چتبات هوش مصنوعی بینگ از سوالی درباره خطرات هوش مصنوعی

B حریم خصوصی

نقض حریم خصوصی (به خاطر استفاده هوشهای مصنوعی از دادههای شخصی افراد نظیر متنها، صدا، تصاویر و دادههای زیستی بدون اجازه گرفتن از صاحبان آنها) و همچنین حقوق مالکیت محتوا (به خاطر استفاده غیرقانونی هوشهای مصنوعی از محتوای کتابها و سایتها برای آموزش خود) از جمله چالشهای حقوقی توسعه هوش مصنوعی در دنیاست.

B تهدید مشاغل

رشد و توسعه هوش مصنوعی، مثل هر فناوری دیگری تبعات فرهنگی و اقتصادی با خود به همراه دارد. برای مثال خطر از بین رفتن مشاغل (برخی برآوردها حاکی از حذف 800 میلیون شغل در جهان تا سال 2030 است)[4] از جمله آنهاست. البته این تهدید بیشتر متوجه مشاغل روتین و یکنواخت است که قابل واسپاری به سامانههای خودکار باشد. در عوض با توجه به ماهیت هوش مصنوعی و چگونگی توسعه آن، به نظر نمیرسد این فناوری همچنان بتواند جایگزین مشاغل خلاق و مولد اندیشه شود.

B خلاقیت و مالکیت معنوی

ازآنجاکه تکیه هوش مصنوعی بر الگوهای آموخته شده از دادههای ورودی پیشین است، درباره اینکه اساساً «آیا هوش مصنوعی صاحب قدرت خلاقیت و تفکر است؟» اختلاف نظرهای جدی فلسفی وجود دارد.

شکل 53: هوش مصنوعی موتور جستجوی بینگ در پاسخ به سوالی درباره معرفی خود، صرفاً مفاهیم ثابتی را در ساختار جملات متفاوت تکرار میکند.

اما اگر حتی روزی پذیرفته شود – یا حدی از پیشرفت حاصل شود – که هوش مصنوعی واقعاً دارای قدرت خلق ایده و صاحب نظر باشد، مسئله کپیرایت آن نیز چالش برانگیز خواهد بود؛ آیا هوش مصنوعی میتواند چیزی اختراع کند و اگر کرد، مالکیت آن برای کیست؟!

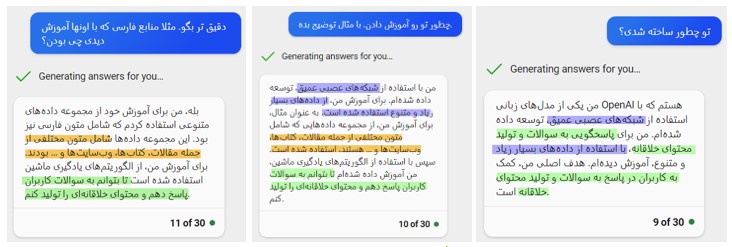

خطر دیگر هوشهای مصنوعی، تولید پاسخهای غیرعلمی و نادرست است. بهطوریکه در مواردی مشاهده میشود که در پاسخ به پرسش کاربر، هوش مصنوعی اقدام به خلق جواب و نسبت دادن آن به منابع غیرواقعی میکند. موضوعی که ضرورت احتیاط و بازنگری پاسخهای تولید شده توسط این ابزارها میطلبد.

شکل 54: هوش مصنوعی جمینای «علی کریمی»، «سعید معروف»، «حامد کمیلی» و … را جزو کسانی معرفی میکند که در حوزه عملیه قم تحصیل کردهاند.

B آسیبهای محیط زیستی

در کنار این، توسعه هوش مصنوعی آسیبهای محیط زیستی جدی نیز در پی دارد؛ چراکه پردازش این حجم بالا از اطلاعات و پاسخگویی به نیازهای کاربران، نیازمند مصرف برق بسیار بالا و همچنین سامانههای خنکسازی سرورهاست. برای مثال، به ازای 10 الی 50 پاسخ چتجیپیتی به جستار کاربران، تقریباً 500 میلیلیتر آب مصرف میشود. همچنین طبق برخی برآوردها، پیشبینی میشود مصرف آب فناوری هوش مصنوعی در جهان تا سال 1406/2027 معادل 4 تا 6 برابر کل مصرف یکساله کشور دانمارک باشد![5] و [6]

شکل 55: خارج شدن بخار آب از برجهای خنکسازی سرورهای شرکت گوگل در ایالت اورگن آمریکا[7]

B تفسیرپذیری تصمیمات و پذیرش مسئولیت آنها

یکی از بزرگترین چالشهای هوش مصنوعی، به خصوص در حوزه یادگیری عمیق، عدم توانایی در تفسیر دقیق تصمیمگیریهای الگوریتمها است. این مسئله به ویژه در مواردی که تصمیمات هوش مصنوعی بر زندگی افراد تأثیرگذار است، بسیار مهم است؛ اینکه هوش مصنوعی چرا و براساس چه معیارهایی یک تصمیم را گرفته است؟

علت این موضوع از آنجا نشأت میگیرد که بسیاری از الگوریتمهای هوش مصنوعی به قدری پیچیده هستند که حتی توسعهدهندگان نیز نمیتوانند به طور کامل نحوه کار آنها را توضیح دهند. این عدم شفافیت میتواند منجر به مشکلات در شناسایی و رفع خطاها، سوگیریها و تصمیمگیریهای نادرست شود.

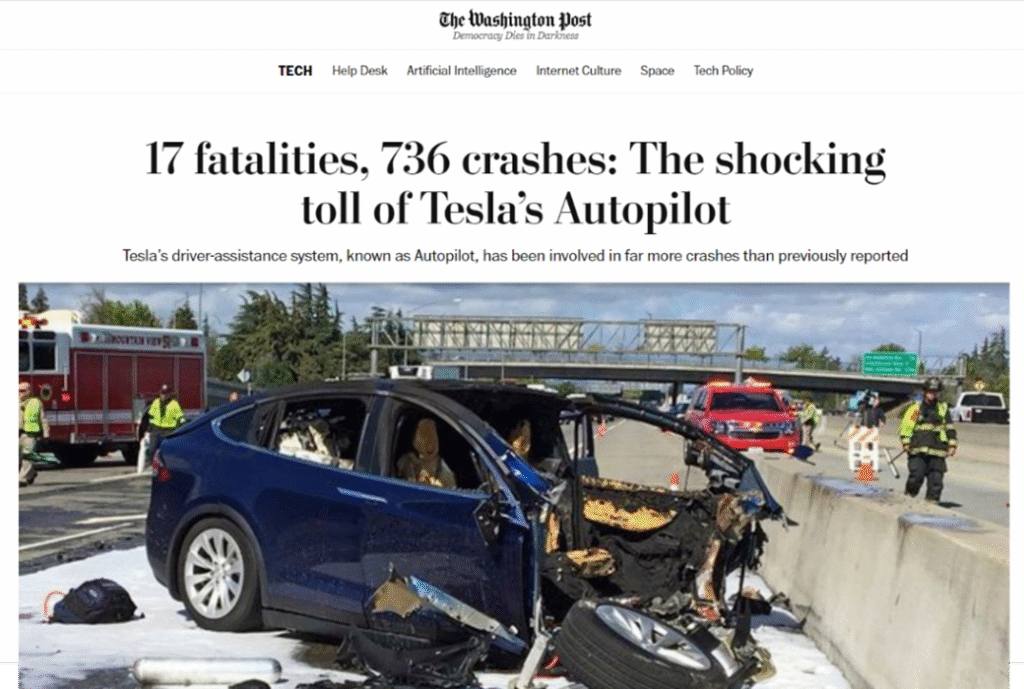

از طرف دیگر در زمینه مسئولیت تصمیمات هوش مصنوعی نیز ابهام وجود دارد. بدین معنی که در صورت بروز خطا یا آسیب ناشی از تصمیمگیری یک سیستم مبتنی بر هوش مصنوعی، مشخص نیست که چه کسی مسئول خواهد بود. این مسئله به ویژه در حوزههایی مانند خودروهای خودران یا هوشهای مصنوعی مربوط به تشخیصهای پزشکی بسیار حیاتی و مهم است.

شکل 56: گزارش خبرگزاری «واشنگتن پست» از 736 تصادف و 17 کشته خودروهای خودران و مبتنی بر هوش مصنوعی شرکت تسلا در سال ۲۰۲۳ [8]

B نتیجهگیری

در راستای مدیریت همین چالشهای فردی و اجتماعیست که مسئله قاعدهگذاری برای توسعه هوش مصنوعی در دنیا به طور جدی در حال پیگیری است. مثلاً:

- برخی دولتها برای مقابله با نشر محتوای جعلی، شرکتهای سازنده هوشهای مصنوعی را ملزم به توسعه همزمان و موازی ابزارهای شناسایی تولیدات هوش مصنوعی کردهاند.[9]

- رسانههای اجتماعی پرسشوپاسخ اینترنتی پاسخهای تولید شده توسط هوشهای مصنوعی مدل زبانی را نامعتبر دانسته و آنها را ثبت نمیکنند.[10]

- شرکتهای توسعهدهنده هوش مصنوعی برای جلوگیری از ایجاد وابستگی عاطفی، در پاسخ به سؤالات احساسی کاربران بر ماشین بودن ابزار خود تأکید میکنند.

شکل 57: پاسخ چتبات بینگ به ابراز احساسات کاربر

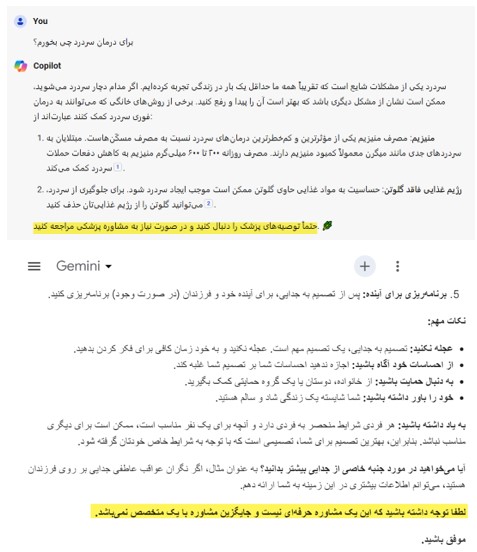

- اغلب چتباتهای هوش مصنوعی در پاسخ به پرسشهای حساس (برای مثال مشاورههای پزشکی) تأکید میکنند که بهتر است برای اطلاعات بیشتر به پزشک مراجعه شود.

شکل 58: تاکید چتباتهای کوپایلوت و جمینای بر مراجعه به متخصص در پاسخ به پرسشهای پزشکی و مشاورهای

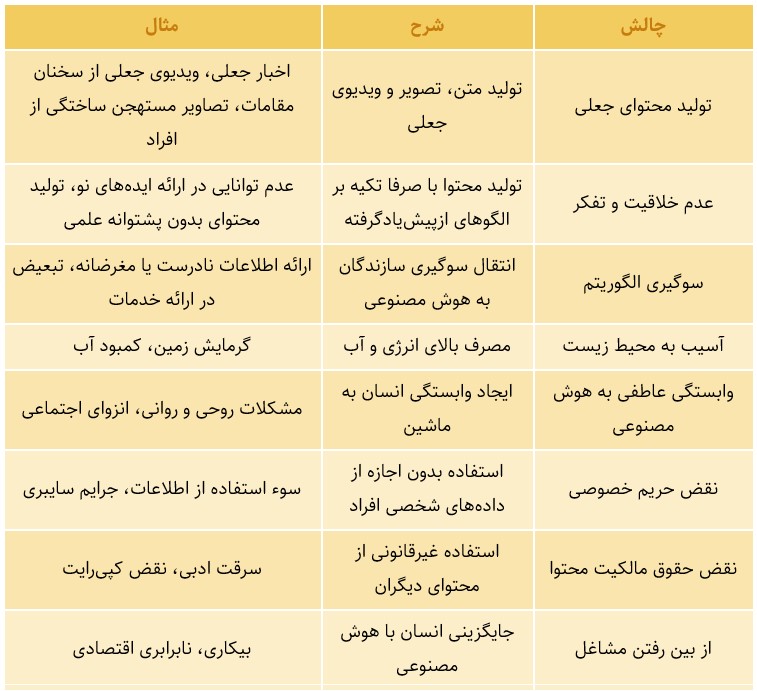

جدول 4: خلاصه برخی از چالشهای توسعه هوش مصنوعی

[1] https://b2n.ir/israel-ai-newsmeterin

[2] https://b2n.ir/trump-ai-indiatvnews

[3] Affective Computing

[4] https://www.digikala.com/mag/is-ai-dangerous-5-immediate-risks-of-artificial-intelligence

[5] https://arxiv.org/abs/2304.03271

[6] https://oecd.ai/en/wonk/how-much-water-does-ai-consume

[7] https://www.oregonlive.com/silicon-forest/2022/12/googles-water-use-is-soaring-in-the-dalles-records-show-with-two-more-data-centers-to-come.html

[8] https://www.washingtonpost.com/technology/2023/06/10/tesla-autopilot-crashes-elon-musk/

[9] https://zaviehmag.ir/?p=12301

[10] https://www.theregister.com/2022/12/05/stack_overflow_bans_chatgpt