رایانش کوانتومی

- دستهبندی: دانش شبکه

- تاریخ:

برای درک بهتر اینکه رایانش کوانتومی چیست، باید ابتدا متوجه شد محاسبات و رایانش در کامپیوترهای عادی و غیرکوانتومی چگونه صورت میگیرد.

B طرز کار کامپیوتر کلاسیک

در زبان انگلیسی واژه «Computing» به معنی محاسبهکردن است و برایناساس «کامپیوتر» (Computer) وسیلهای است که محاسبات را انجام میدهد.

این نامگذاری ازآنجهت است که تمام سیستمهای دیجیتالی که در زندگی روزمره استفاده میشوند در واقع دادهها را بهصورت اعداد باینری (ترکیب رقمهای ۰ و 1) ذخیره میکنند. در سمت دیگر زمانی که کاربر دستوری را بهصورت کلیک یا تایپ و فشردن دکمهای وارد میکند، کامپیوتر آن را از طریق اعمال ریاضی و محاسبه مقادیر جدید متغیرها اجرا کرده و تغییرات مورد نظر را صورت میدهد.

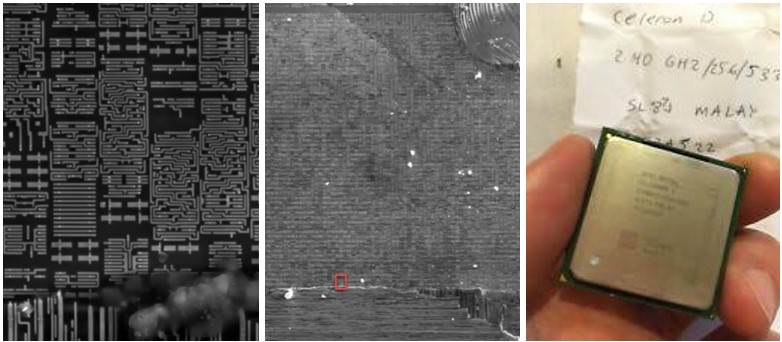

این عمل ذخیرهسازی و پردازش اطلاعات توسط تراشهای انجام میشود که از میلیونها قطعه الکترونیکی بسیار ریز به نام «ترانزیستور» تشکیل شده است. هر ترانزیستور مانند یک کلید چراغ اتاق عمل میکند؛ یا روشن است یا خاموش. روشن بودن ترانزیستور به معنی ذخیره عدد 1 و خاموش بودن آن به معنی عدد ۰ است. بر این مبنا تراشهها میتوانند به کمک ترانزیستورهای روی خود، اطلاعات را در قالب اعداد باینری ذخیره کرده و تغییرات جدید بر آنها را از طریق محاسبات ریاضی انجام داده و اعمال کنند. لذا یکی از عوامل مؤثر بر قدرت پردازشی تراشه، ابعاد ترانزیستورهای آن است؛ هر چه ترانزیستورها کوچکتر شوند، تعداد بیشتری از آنها روی تراشه با ابعاد ثابت قرار میگیرد و ازاینرو میزان حافظه و سرعت پردازش اطلاعات بالاتر میرود.

شکل 53: پردازنده «Intel Celeron D320» ساخته سال ۱۳۸۳/۲۰۰۴ دارای ۱۲۵ میلیون ترانزیستور ۹۰ نانومتری (تصویر راست) و نمای زیرمیکروسکپی بخشی از آن (مربع کوچک)[1] و [2]

جدول 15: مقایسه مشخصات تراشه دستگاههای مختلف

از سال ۱۳۲۶/1947 که نخستین ترانزیستور اختراع شد، روند کوچک شدن ترانزیستورها و افزایش تعداد آنها روی تراشه با ابعاد ثابت، سرعت ثابتی داشت که به آن قانون «مور»[3] میگفتند. طبق این قانون تجربی، سرعت پیشرفت فناوریهای مربوط به صنعت تراشه به گونهای است که تقریباً هر 18 ماه تعداد ترانزیستورهایی که میتوان روی یک تراشه قرار داد (و به تبع آن قدرت پردازش اطلاعات تراشه) دو برابر میشود.

این قانون اگرچه در پنج دهه گذشته برقرار بوده است، اما در چند سال اخیر با رسیدن ابعاد ترانزیستورها به زیر 10 نانومتر، دیگر ادامه روند قبلی ممکن نیست. چراکه ابعاد ترانزیستورها به ابعاد اتم نزدیک شده و در این صورت بهجای فرمولهای فیزیک نیوتن، قوانین فیزیک کوانتومی حکمفرما میشود و شرایط به کل تغییر میکند. ازاینرو کار برای کوچکسازی بیش از پیش ترانزیستورها و ساخت تراشههای قدرتمندتر دشوار میشود.[4]

B کامپیوتر کوانتومی

برای عبور از محدودیتهای پردازندههای رایج، کامپیوترهای کوانتومی بهجای منطق باینری، از قوانین محاسبات کوانتومی استفاده میکنند. در اینگونه محاسبات، مقدار یک بیت – که در کامپیوتر کوانتومی به آن «کیوبیت» (Qubit) میگویند – دیگر فقط صفر یا یک نیست و طبق «اصل برهمنهی» فیزیک کوانتوم، میتواند بهصورت همزمان هم یک باشد و هم صفر.[5]

شکل 54: بیان مفهومی از تفاوت «بیت» و «کیوبیت»

اما قابلیت منحصربهفرد کیوبیتها در ذخیرهسازی چندین حالت به طور همزمان، به کامپیوترهای کوانتومی اجازه میدهد تا دادهها را بهصورت موازی و با سرعتی بینظیر محاسبه کنند. این در حالی است که رایانههای کلاسیک دادهها را بهصورت سریالی و یکی پس از دیگری پردازش میکنند. ازاینرو کامپیوترهای کوانتومی میتوانند عملیاتهای محاسباتی را با سرعتی بسیار بالاتر از کامپیوترهای سنتی انجام دهند.

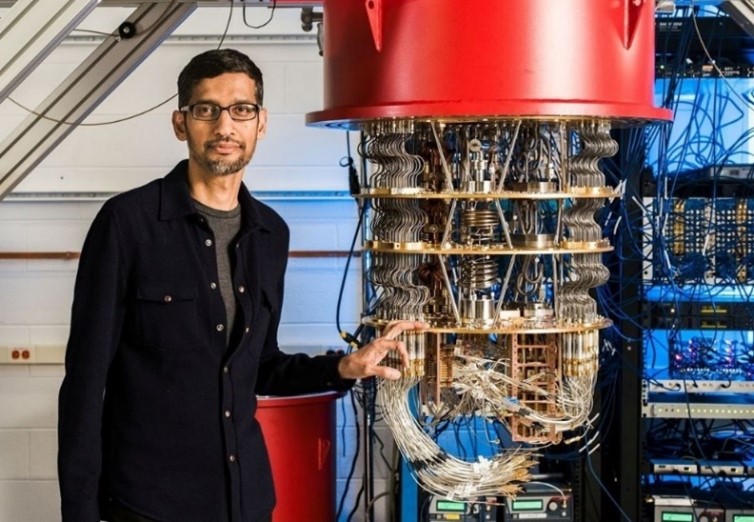

شکل 55: آقای «سوندار پیچای» (مدیرعامل گوگل) در کنار پردازنده کوانتومی ۵۳ کیوبیتی این شرکت[6]

B کاربرد رایانش کوانتومی

بهطورکلی باید توجه داشت که محاسبات کوانتومی روی کیوبیتها بهشدت به نویز و اختلال محیطی حساس بوده و نیازمند شرایط خاصی مثل ایجاد خلأ یا دمای خیلی پایین (در حد صفر مطلق کلوین[7]) است. ازاینرو احتمال اینکه در آینده تراشههای کوانتومی در تلفن همراه یا کامپیوترهای خانگی استفاده شوند بعید به نظر میرسد.

از طرفی برای کاربردهای روزمره، تراشههای فعلی بهاندازه کافی قدرتمند و سریع هستند و اساساً هنوز نیازی برای جایگزینکردن پردازندههای کلاسیک با کوانتومی وجود ندارد. ضمن اینکه گسترش ایده «رایانش ابری» بر بستر شبکه اینترنت – یعنی نصب نرمافزارهای سنگین بر روی سرورها و استفاده آنلاین کاربران از آنها – عطش و نیاز بازار به پردازندههای قویتر از آنچه هماکنون موجود است را گرفته است.

اما در عوض کامپیوترهای کوانتومی باتوجهبه توان و سرعت پردازش بالایی که دارند، برای حل هر نوع مسئله چندمتغیره و پیچیده که نیازمند محاسبات و تحلیلهای سنگین است، کاربرد دارد.

برای مثال یکی از کاربردهای بالقوه کامپیوترهای کوانتومی – که نگرانیهای بسیاری را نیز برانگیخته است – در زمینه رمزنگاری و امنیت سایبری است. چراکه کشف رمز عبورهای رایج برای کامپیوترهای کلاسیک زمانبر است. درحالیکه کامپیوترهای کوانتومی به کمک سرعت بالای پردازش و محاسباتی که دارند میتواند در زمان بسیار کوتاهی هر رمزی را پیدا کنند.

کاربرد مهم دیگر کامپیوترهای کوانتومی، در زمینه هوش مصنوعی است. در واقع ازآنجاکه هوشهای مصنوعی متکی بر یادگیری از روی کلاندادهها هستند، کامپیوترهای کوانتومی میتوانند با پردازش سریع انبوه دادهها برای مقاصد مختلفی مثل افزایش دقت تشخیص تصاویر و اشیا، پردازش زبان طبیعی پیشرفتهتر و تولید متنهای روانتر یا تحلیل دادههای حجیم و پیچیده با سرعتی بالا مورداستفاده قرار گیرند.

جدول 16: برخی کاربردهای رایانش ابری در حوزههای مختلف

[1] https://ark.intel.com/content/www/us/en/ark/products/27107/intel-celeron-d-processor-320-256k-cache-2-40-ghz-533-mhz-fsb.html

[2] https://www.youtube.com/watch?v=7d1eyZBpLn8

[3] Moore’s Law

[4] https://techovedas.com/4-reasons-why-moores-law-might-be-dead-finally

[5] https://quantumai.google/discover/whatisqc

[6] https://b2n.ir/how-quantum-computing-wo

[7] معادل منفی ۲۷۳ درجه سانتیگراد